L’inférence de l’intelligence artificielle s’impose comme un enjeu central pour les centres de données, poussant les acteurs technologiques à innover pour répondre à la demande croissante en puissance de calcul et en efficacité énergétique.

Qualcomm, fort de son expertise, dévoile de nouvelles solutions matérielles conçues pour transformer l’inférence IA à grande échelle.

Voir cette publication sur Instagram

Performances, capacité mémoire, sécurité et flexibilité sont au cœur de cette nouvelle génération d’accélérateurs, pensée pour accompagner l’essor des modèles d’IA générative et offrir aux entreprises une alternative compétitive sur un marché en pleine mutation.

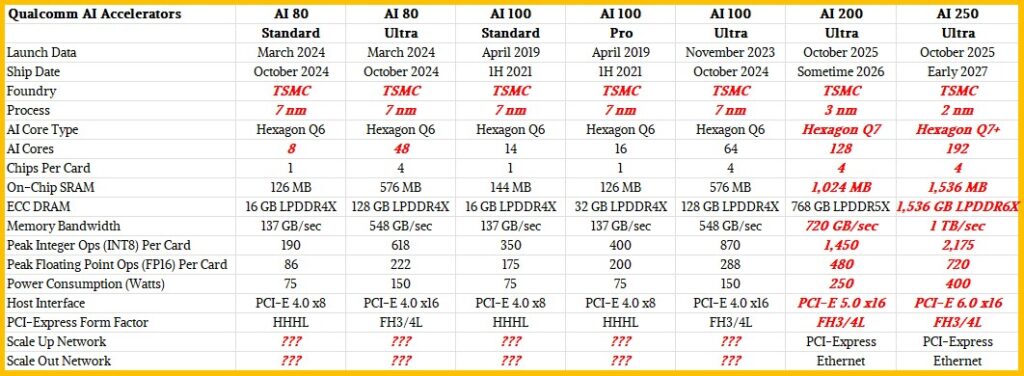

Les solutions Qualcomm AI200 et AI250 : une nouvelle génération pour l’inférence IA en datacenter

Face à l’explosion de la demande en intelligence artificielle générative, Qualcomm dévoile ses nouvelles solutions AI200 et AI250, conçues pour révolutionner l’inférence IA dans les centres de données.

Positionnées comme des alternatives performantes et économes aux offres existantes, ces plateformes misent sur une efficacité énergétique accrue, une capacité mémoire supérieure et un coût total de possession (TCO) réduit.

L’AI200 cible les modèles de langage et multimodaux avec 768 Go de mémoire par carte, tandis que l’AI250 innove avec une architecture mémoire avancée, promettant une bande passante décuplée et une consommation énergétique optimisée.

Voir cette publication sur Instagram

Avec cette double offensive, Qualcomm entend répondre aux besoins croissants des entreprises en matière de déploiement d’IA à grande échelle.

Caractéristiques techniques et innovations matérielles

Les AI200 et AI250 se distinguent par des avancées matérielles majeures : l’AI200 propose 768 Go de mémoire LPDDR par carte, garantissant une gestion fluide des modèles d’IA volumineux.

L’AI250 franchit un cap avec une architecture mémoire proche du calcul, offrant une bande passante plus de dix fois supérieure et une efficacité énergétique accrue.

Les deux solutions intègrent un refroidissement liquide direct, une connectivité PCIe pour l’extension verticale et Ethernet pour le maillage horizontal, tout en limitant la consommation à 160 kW par rack.

Ces innovations répondent aux exigences des datacenters modernes, en optimisant la performance, la sécurité et la flexibilité pour l’inférence de modèles d’IA toujours plus complexes et gourmands en ressources.

Écosystème logiciel, compatibilité et sécurité

Qualcomm accompagne ses solutions AI200 et AI250 d’une pile logicielle complète, pensée pour une intégration transparente dans les environnements d’entreprise.

Meet Qualcomm AI200 and Qualcomm AI250—rack-scale inference solutions built for the #AI era. Launching in 2026 and 2027. Learn more here: https://t.co/cPjXY2fuuV pic.twitter.com/emnuR5J6DS

— Qualcomm (@Qualcomm) October 27, 2025

Compatible avec les principaux frameworks d’IA, la suite prend en charge le déploiement en un clic de modèles Hugging Face via la bibliothèque Efficient Transformers et la plateforme Qualcomm AI Inference.

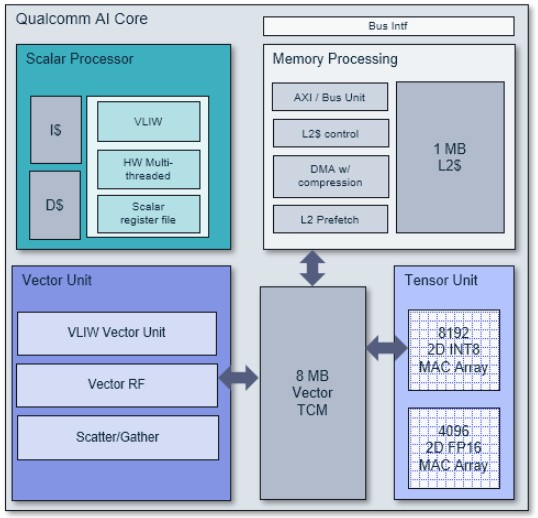

Voici à quoi ressemble le cœur d’IA de Qualcomm :

Les outils proposés facilitent la gestion, l’optimisation et la mise à l’échelle des modèles, tout en assurant la sécurité des données grâce au calcul confidentiel.

Cette approche ouverte et modulaire permet aux entreprises de déployer rapidement des applications d’IA générative, tout en bénéficiant d’un haut niveau de protection et d’une interopérabilité optimale avec les standards du secteur.

Feuille de route, partenariats stratégiques et ambitions de Qualcomm

Qualcomm affiche une feuille de route ambitieuse pour s’imposer dans l’infrastructure IA des datacenters, avec la disponibilité de l’AI200 prévue en 2026 et de l’AI250 en 2027, suivies d’une nouvelle génération dès 2028.

Ce calendrier annuel témoigne d’une volonté d’innovation continue, soutenue par des partenariats stratégiques, notamment avec Humain pour le déploiement de 200 MW de matériel en Arabie saoudite.

En misant sur des solutions à faible TCO, une efficacité énergétique supérieure et une compatibilité logicielle étendue, Qualcomm entend concurrencer les géants du secteur comme Nvidia.

Sa stratégie s’appuie sur l’agilité, l’ouverture de son écosystème et la capacité à répondre aux besoins croissants en IA générative, positionnant l’entreprise comme un acteur incontournable du datacenter de demain.